V. Le protocole http2▲

Assez sur la gestation et la politique qui nous ont menÃĐs ici. Plongeons dans les spÃĐcificitÃĐs du protocole : les dÃĐtails et concepts qui font http2.

V-A. Binaire▲

http2 est un protocole binaire.

Posons-nous un moment. Si vous avez dÃĐjà travaillÃĐ sur des choix de protocoles IP par le passÃĐ, il est probable que votre premiÃĻre rÃĐaction soit nÃĐgative, et que vous argumentiez que les protocoles textuels sont bien supÃĐrieurs, car les Êtres humains peuvent forger des requÊtes à la main via telnet, etc.

http2 est binaire pour rendre le dÃĐcoupage (framing en anglais) plus simple. Trouver le dÃĐbut et la fin d'une trame en HTTP 1.1 et dans les protocoles textuels en gÃĐnÃĐral est toujours trÃĻs compliquÃĐ. En ÃĐvitant les blancs optionnels et les diverses façons d'ÃĐcrire la mÊme chose, les implÃĐmentations sont plus simples.

De plus, cela permet de sÃĐparer plus nettement les parties du protocole et le dÃĐcoupage. Ce manque de sÃĐparation nette a toujours ÃĐtÃĐ perturbant avec HTTP1.

Le fait que le protocole utilise la compression et TLS diminue la valeur ajoutÃĐe de garder du texte pur puisqu'on ne verra pas de texte en clair passer de toute façon. Nous devons simplement nous habituer à utiliser un analyseur de trafic type Wireshark pour comprendre exactement ce qu'il se passe au niveau protocolaire http2.

DÃĐbugger ce protocole se fera du coup probablement via des outils type curl ou le dissecteur http2 de Wireshark.

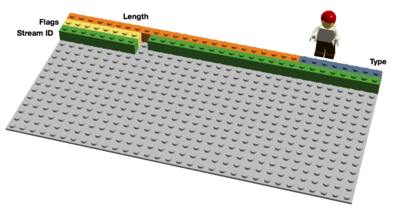

V-B. Le format binaire▲

|

http2 envoie des trames binaires. Il y a diffÃĐrents types de trames envoyÃĐes et elles ont toutes le mÊme format : |

|

V-C. Multiplexage de flux▲

L'identifiant de flux (Stream Identifier) mentionnÃĐ dans le chapitre prÃĐcÃĐdent permet d'associer à chaque trame http2 un ÂŦ flux Âŧ (stream). Un flux est une association logique : une sÃĐquence indÃĐpendante et bidirectionnelle de trames ÃĐchangÃĐes entre un client et un serveur via une connexion http2.

Une seule connexion http2 peut contenir plusieurs flux simultanÃĐs, avec chaque extrÃĐmitÃĐ de la connexion pouvant entrelacer les flux. Les flux sont ÃĐtablis et utilisÃĐs unilatÃĐralement ou de concert par le client ou le serveur. Ils peuvent Être terminÃĐs par l'un ou l'autre cÃītÃĐ de la connexion. L'ordre d'envoi des trames dans un flux est important. Le traitement des trames reçues se fait dans l'ordre de rÃĐception.

Multiplexer des flux implique que des groupes de trames sont mÃĐlangÃĐs (ou ÂŦ mixÃĐs Âŧ) sur une mÊme connexion. Deux (ou plusieurs) trains de donnÃĐes sont fusionnÃĐs en un seul puis scindÃĐs à nouveau à la rÃĐception. Voici deux trains :

Ils sont mÃĐlangÃĐs l'un dans l'autre sur la mÊme connexion via multiplexage :

En http2, nous allons voir des dizaines voire des centaines de flux simultanÃĐs. Le coÃŧt de crÃĐation d'un nouveau flux est trÃĻs faible.

V-D. PrioritÃĐs et dÃĐpendances▲

Chaque flux a une prioritÃĐ (ou ÂŦ poids Âŧ), utilisÃĐe pour dire à l'autre extrÃĐmitÃĐ de connexion quels flux sont importants, en cas de congestion (manque de ressources) forçant le serveur à faire un choix sur les trames à envoyer en premier.

En utilisant la trame PRIORITY, un client peut indiquer au serveur quel autre flux dÃĐpend du flux actuel. Cela permet au client de construire un ÂŦ arbre Âŧ de prioritÃĐs dans lequel des ÂŦ flux enfants Âŧ dÃĐpendront de la rÃĐussite des ÂŦ flux parents Âŧ.

Les prioritÃĐs peuvent changer dynamiquement, ce qui permettra aux navigateurs d'indiquer quelles images sont importantes quand on fait dÃĐfiler une page remplie d'images, ou encore de prioriser les flux affichÃĐs à l'ÃĐcran quand on passe d'un onglet à un autre.

V-E. Compression de l'en-tÊte.▲

HTTP est un protocole sans ÃĐtat (state-less). Cela veut dire que chaque requÊte doit apporter tous les dÃĐtails requis au serveur pour traiter la requÊte, sans que le serveur ait besoin de conserver les informations ou mÃĐtadonnÃĐes des requÊtes prÃĐcÃĐdentes. Comme http2 ne change pas ce principe, il doit en faire de mÊme.

Cela rend HTTP rÃĐpÃĐtitif. Quand un client demande plusieurs ressources d'un mÊme site, comme les images d'un site web, il y aura une sÃĐrie de requÊtes quasi identiques. Une sÃĐrie de points identiques appelle un besoin de compression.

Le nombre d'objets par page web croÃŪt comme vu prÃĐcÃĐdemment, l'utilisation de cookies et la taille des requÊtes croÃŪt ÃĐgalement. Les cookies sont inclus dans toutes les requÊtes, souvent identiques sur plusieurs requÊtes.

Les tailles de requÊtes HTTP 1.1 sont devenues tellement importantes qu'elles dÃĐpassent parfois la taille de la fenÊtre TCP initiale, ce qui rend le tout trÃĻs lent puisqu'un aller-retour est nÃĐcessaire pour qu'un ACK soit envoyÃĐ par le serveur. Encore une bonne raison de compresser.

V-E-1. La compression est un sujet dÃĐlicat▲

Les compressions HTTPS et SPDY ont ÃĐtÃĐ vulnÃĐrables aux attaques BREACH et CRIME. En insÃĐrant un texte connu dans le flux et en analysant les changements rÃĐsultants, l'attaquant peut dÃĐduire ce qui a ÃĐtÃĐ envoyÃĐ.

Compresser du contenu dynamique sans devenir vulnÃĐrable à une de ces attaques requiert de la rÃĐflexion. L'ÃĐquipe HTTPbis s'y attelle.

Voici HPACK, Header Compression for HTTP/2 (compression d'en-tÊte pour HTTP/2), qui, comme son nom l'indique, est un format de compression spÃĐcialement crÃĐÃĐ pour les en-tÊtes http2 et spÃĐcifiÃĐ dans un draft IETF distinct. Le nouveau format, avec d'autres contre-mesures comme un bit qui interdit aux intermÃĐdiaires de compresser un en-tÊte spÃĐcifique ou du remplissage de trames (padding), devrait rendre plus compliquÃĐe l'exploitation de cette compression.

Voici les mots de Roberto Peon (l'un des crÃĐateurs de HPACK)Â :

ÂŦ HPACK a ÃĐtÃĐ conçu pour rendre difficile la fuite d'information avec une implÃĐmentation s'y conformant, rendre le codage et dÃĐcodage trÃĻs rapide et peu coÃŧteux, fournir au destinataire un contrÃīle sur la taille du contexte de compression, permettre une rÃĐindexation par un proxy, et permettre une comparaison rapide avec des chaÃŪnes codÃĐes avec un algorithme Huffman. Âŧ

V-F. Reset - changez de perspective▲

Un des inconvÃĐnients de HTTP 1.1 : quand le message HTTP est envoyÃĐ avec un en-tÊte Content-Length d'une taille particuliÃĻre, on ne peut pas l'interrompre facilement. Bien sÃŧr vous pouvez toujours terminer la session TCP, mais cela a un coÃŧt : renÃĐgocier le handshake TCP.

Une meilleure solution serait simplement d'interrompre le message et en dÃĐmarrer un nouveau. Cela peut se faire en http2 avec la trame RST_STREAM qui permet d'ÃĐviter de gÃĒcher de la bande passante et de terminer des connexions TCP.

V-G. Server push▲

Cette fonctionnalitÃĐ est aussi connue comme ÂŦ cache push Âŧ. Cas typique : un client demande une ressource X au serveur, le serveur sait qu'en gÃĐnÃĐral ce client aura besoin de la ressource Z par la suite et la lui envoie sans que le client l'ait demandÃĐe. Cela aide le client à mettre Z dans son cache pour qu'elle soit disponible quand il en aura besoin.

Le Push Serveur (Server Push) doit Être explicitement autorisÃĐ par le client et, quand bien mÊme le client l'autorise, ce dernier se rÃĐserve le droit de terminer un flux ÂŦ poussÃĐ Âŧ avec un RST_STREAM.

V-H. ContrÃīle de flux▲

Chaque flux individuel en http2 a sa propre fenÊtre de flux annoncÃĐe que l'autre extrÃĐmitÃĐ du flux peut utiliser pour envoyer des donnÃĐes. Si vous savez comment SSH fonctionne, le principe est trÃĻs similaire.

Pour chaque flux, les deux extrÃĐmitÃĐs doivent indiquer qu'ils ont davantage de place pour accepter des donnÃĐes supplÃĐmentaires, l'autre extrÃĐmitÃĐ est autorisÃĐe à envoyer ce volume de donnÃĐes uniquement jusqu'à l'extension de la fenÊtre. Seules les trames DATA (donnÃĐes) bÃĐnÃĐficient du contrÃīle de flux.